3月1日,ChatGPT概念股大幅反弹,其中还爆发一个新市场细分——GPT4.0下的多模态。

事实上,近段时间ChatGPT火爆全球,但其仍是GPT的3.5版本,基于其惊人的表现,外界对于下一代的GPT-4充满期待。

据《财富》杂志报道,OpenAI还有更多创新蓄势待发,OpenAI在贝塔测试版GPT-4中采用了更强大的大语言模型,预计该版本将于今年甚至很快发布。

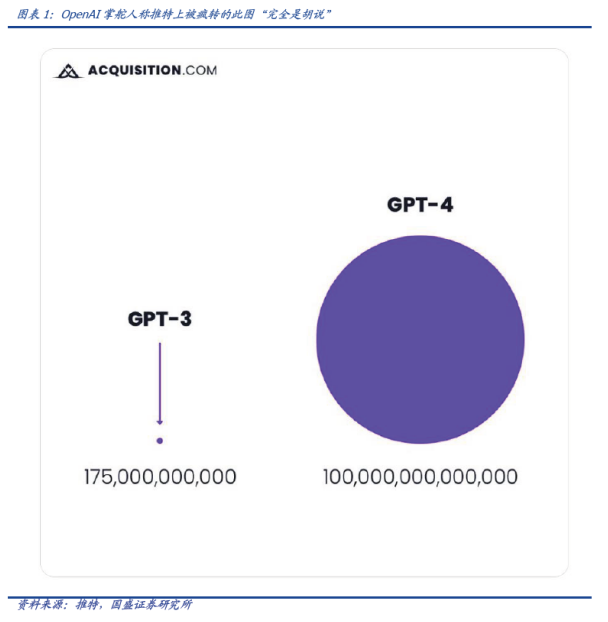

2023年1月18日的一场公开采访中,当OpenAI的CEO Sam Altman被问及一张在推特上被疯转的图表时(该图表称GPT-3拥有1750亿参数,而GPT-4可能拥有100万亿参数),Altman称其“完全是胡说”,这证明了即将到来的GPT4可能不会往一味巨幅扩大参数量的方向去走,而可能向其他方向寻求提升。

多模态或许是下一代GPT的大杀器

那GPT4究竟可能往哪些方向寻求提升呢?国盛证券表示,多模态,或许是CHATGPT的下一站。

所谓多模态模型,就是未来大模型的输入输出可以不仅限于文字,还可以包括图像、视频等多种形式。

国盛证券认为,若GPT4转向多模态,将大幅提升AI视觉方向生产效率,图像、视频等应用将层出不穷涌现。其使用场景将远远不仅限于文字、问答与办公,打开有望未来AI在下游千行百业的应用空间,进一步打开市场想象力。

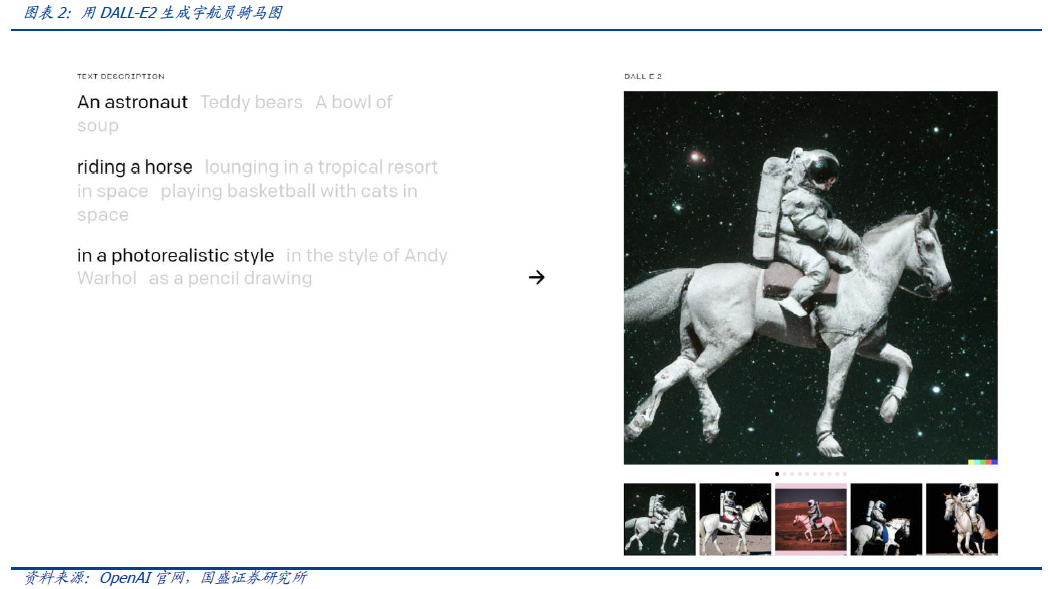

实际上,OpenAI的绘画AI模型DALL-E2就是目前最知名的多模态模型之一。除此之外,其他知名多模态模型还包括在AIGC界引起过巨大反响的Stable Diffusion,以及谷歌推出的音乐生成AI模型MusicLM等。

1)DALL-E 2:OpenAI推出的AI绘画模型,在前代DALL-E的基础之上有了很大提升,可以直接根据文字生成图像,也可以输入图像后、子现成图像上根据文字指令进行部分修改,功能强大。

2)Stable diffusion:由ai公司在去年开源的AI绘画模型,可以通过输入文字生成对应图像。由于效果极佳,模型一经开源即在AIGC界引起极大反响。

国盛证券还提到,由于多模态模型使用图像、视频等多媒体数据进行训练,而此类文件大小远超文字,算力需求有望激增。

1)以Stable diffusion为例,根据公司官网信息披露,该模型训练数据集为LAION 5B的一个子数据集,而LAION 5B的数据包至少80TB,规模已经远超传统语言类大模型训练时使用的数据量(一般是GB级的)。

该模型使用4000块英伟达A100训练了一个月,算力需求庞大。若按AWS官网上租用价格(32.77美元/小时/8 GPU)计算,则该模型训练成本可高达4000/8*32.77*24*30=1179.72万美元。

2)无独有偶,DALL-E2模型在训练时使用了5亿张图片,按单张图片大小512*512像素(约256kb)估算,整体训练数据集大小高达约155TB。

国盛证券表示,由此可见多模态大模型的训练对算力芯片数量需求远胜语言类模型,算力需求有望激增。

来源:爱股票

未经允许不得转载:财富在线 » 多模态,或是下一代GPT的大杀器

评论前必须登录!

登陆 注册